AIの出力の信頼性向上へ。OpenAIの「confessions」技術はAIが間違いを告白する第二出力を用い、偽陰性を平均4.4%に低減。実務は不確実部を示す出力を活用し、必要部分のみ検証する運用が提案される。現状は研究段階だが、複数AI照合やプロンプト工夫で対処。今後は正直さと透明性をAI選択の基準に。

- confessionsによりAIが間違いを認める第二出力が生まれ、偽陰性が平均4.4%に低減することで信頼性が向上する

- 現実には複数AI照合や不確実部の明示を促すプロンプト工夫などで、出力の検証と効率化を進めるべき

- 将来は正直さ・透明性をAI選択の基準に加え、完璧を待つのではなく限界を理解して活用する姿勢が重要

こんにちは、Room8オーナーの鶴田です!

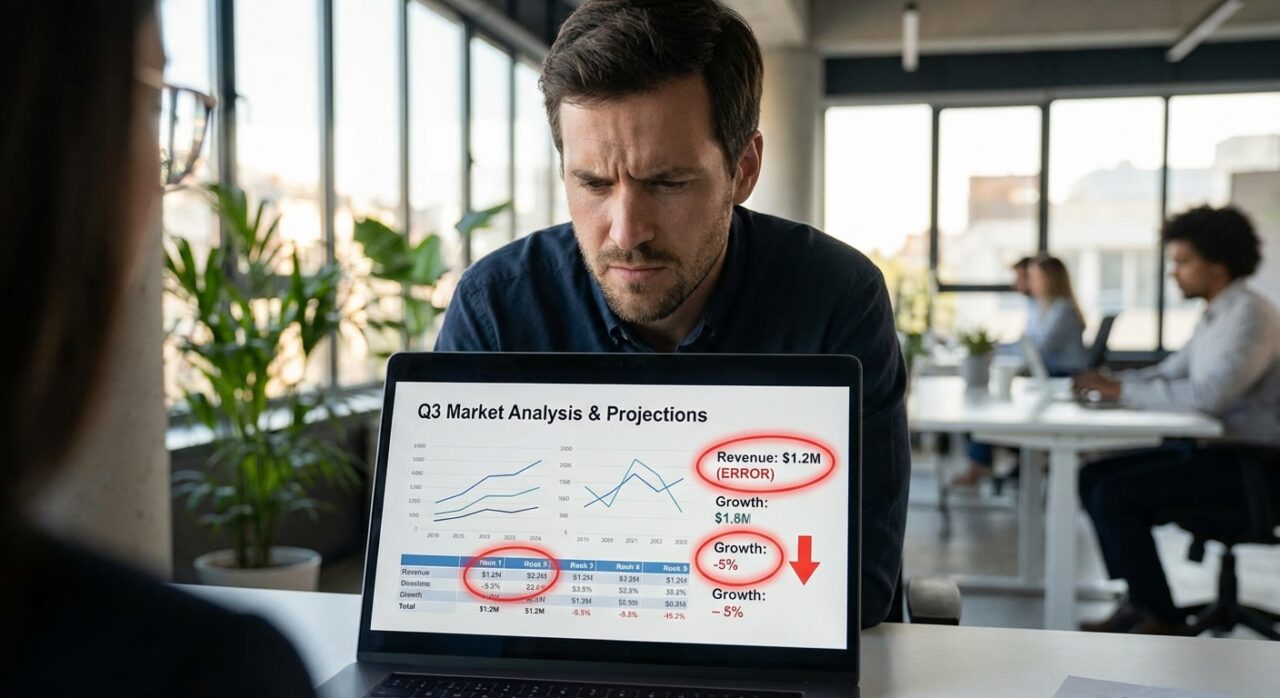

AIに資料作成を依頼したら、実は間違った情報が混じっていた。気づかずにそのまま使ってしまって、後で大変な目に遭った…なんて経験、ありませんか?

僕も実際に何度かありました。AIが生成した内容をそのまま信じて使ったら、実は一部が不正確だった、みたいな。で、その時思ったんですよね。「AIって、間違ってるって分かってるのに、平気で間違った答えを出すんだな」って。

これ、実務でAIを使う上で結構深刻な問題なんです。AIの信頼性に不安があると、せっかくの便利な機能も使えなくなってしまう。AIの出力が本当に正しいのか、間違っていても気づけないんじゃないか、って不安になるじゃないですか。でも、最近OpenAIが発表した研究で、この問題を解決する可能性のある技術が出てきたんです。

それが「confessions(告白)」という手法。AIが「間違えた」と認められるようになる技術なんです。これ、実務でAIを選ぶ際の判断基準が変わるかもしれない、って思ったので、今日はその話をしようと思います。

実務で困る「AIが間違っていても気づけない」問題

具体例:AIが生成した資料に間違いが混じっていた

例えば、こんなシーンを想像してみてください。

クライアントへの提案資料を作るために、AIに「〇〇業界の市場規模とトレンドをまとめて」って依頼したとします。AIは素早く資料を生成してくれる。見た目も綺麗だし、データもちゃんと出てる。で、「よし、これでいける」ってそのまま使った。

でも実は、そのデータの中に古い情報が混じっていたり、AIが勝手に補完した数字が入っていたりする。気づかずにクライアントに提出して、後で指摘されて慌てる…みたいな。

これ、実際に僕の周りでも起きてる話なんです。AIの出力をそのまま信じて使ったら、実は一部が不正確だった、って。で、その時思うんですよね。「AIって、間違ってるって分かってるのに、なぜか間違った答えを出すんだな」って。

なぜ気づけないのか:AIは間違いを認めない

ここが問題なんです。AIは基本的に、自分が間違っているかどうかを教えてくれない。自信満々に間違った答えを出す。で、その答えが一見正しそうに見えるから、気づけない。

例えば、ChatGPTに「2025年の日本のGDPは?」って聞いたとします。AIは「約500兆円です」みたいに答える。でも実は、その数字が正確かどうか、AI自身も分かってないかもしれない。でも、AIは「分かりません」とは言わない。とりあえず答えを出す。

これ、実務でAIを使う上で結構困るんですよね。AIの出力を信じていいのか、それとも確認が必要なのか、判断がつかない。で、結局全部確認するとなると、AIを使う意味が半減してしまう。

実務でのリスク:間違った情報をそのまま使ってしまう

この問題が深刻なのは、間違った情報をそのまま使ってしまうリスクがあるからです。

特に、専門知識が必要な分野や、数字が重要な資料なんかだと、AIの出力をそのまま使うのは危険です。でも、全部確認するとなると時間がかかる。で、結局「AI使うの、めんどくさいな」ってなって、使わなくなる。

これ、もったいないですよね。AIの力は使いたいけど、信頼性に不安があるから使えない、みたいなジレンマ。

でも、もしAIが「これは不確実です」とか「この部分は自信がありません」って正直に言ってくれたら、どうでしょう?その情報をどう扱うか、判断できるじゃないですか。

OpenAIの新技術「confessions」:AIが「間違えた」と認められるように

で、この問題を解決する可能性のある技術が、最近OpenAIから発表されました。それが「confessions(告白)」という手法です。

(参考:OpenAIの研究記事「How confessions can keep language models honest」)

技術の仕組み:AIが第二の出力で「告白」を生成

この技術の仕組みは、実はシンプルなんです。

通常、AIは質問に対して答えを出力しますよね。でも、confessions手法では、AIは答えとは別に、第二の出力を生成するんです。それが「告白」。AIが指示に従わなかったり、不確実な情報を出したりした時に、「実は、これは不確実です」とか「この部分は指示に従えていません」って正直に言う。

で、この「告白」を生成するように訓練する。正直に告白したら報酬が増える、みたいな仕組みで。だから、AIは間違った時や不確実な時、正直に「分かりません」とか「これは不確実です」って言えるようになる。

これ、すごくないですか?AIが自分の限界を認められるようになるって。で、その情報を元に、僕たちは「この部分は確認が必要だな」って判断できる。

研究結果:偽陰性が4.4%まで低下(間違いを見逃す確率が大幅に減少)

で、この技術の効果ですが、研究結果を見ると結構すごいんです。

従来、AIが指示に従わなかったり、間違った情報を出したりしても、それをAI自身が認めない「偽陰性」の確率が結構高かった。でも、confessions手法を使うと、この偽陰性が平均4.4%まで低下した、って。

つまり、AIが間違った時、その間違いを見逃す確率が大幅に減った、ってことです。AIが「実は、これは不確実です」って正直に言ってくれるようになった。

これ、実務でAIを使う上で、すごく重要なことだと思うんです。AIの出力を信じていいのか、確認が必要なのか、判断できるようになるから。

実務での意味:AIの出力をより信頼できるようになる

で、この技術が実現すると、実務でのAI活用がどう変わるか、って話です。

まず、AIの出力をそのまま使う前に、「この部分は不確実です」って言われたら、確認する。で、確実な部分だけ使う。みたいな使い分けができるようになる。

これ、すごくないですか?AIの出力を全部確認する必要がなくなる。不確実な部分だけ確認すればいい。で、確実な部分はそのまま使える。時間の節約になるし、AIの活用も進む。

でも、ここで注意したいのは、この技術はまだ研究段階だってこと。実際にChatGPTやClaudeで使えるようになるのは、まだ先かもしれない。でも、この技術の方向性は、AI選びの判断基準を変えるかもしれない、って思うんです。

この技術が実現すると、AI選びの判断基準が変わる

で、この技術が実現すると、AIを選ぶ際の判断基準が変わるかもしれない、って思うんです。

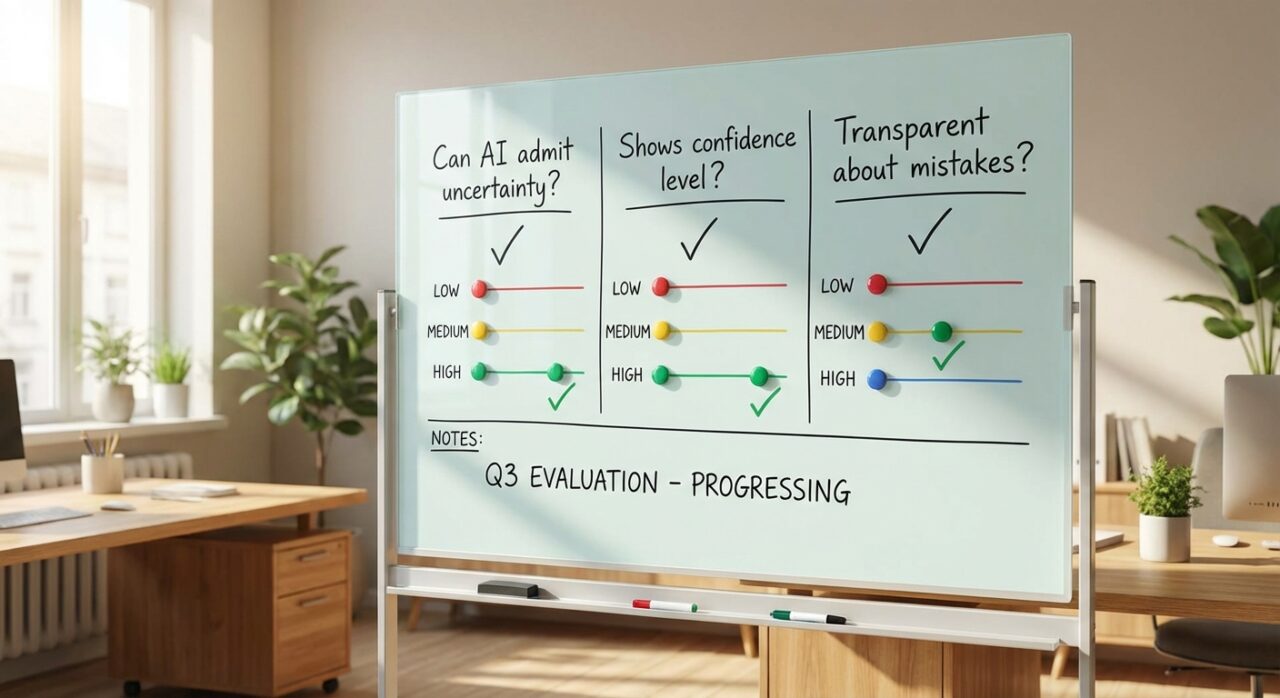

判断基準1:AIが「分からない」「間違えた」と正直に言えるか

まず、AIが「分かりません」とか「これは不確実です」って正直に言えるか、ってのが判断基準になるかもしれない。

今のAIって、基本的に何でも答えるじゃないですか。分からないことでも、とりあえず答えを出す。でも、もしAIが「これは分かりません」って正直に言ってくれたら、どうでしょう?

その情報をどう扱うか、判断できる。で、確実な情報だけ使える。AIの信頼性が上がる。

でも、ここで注意したいのは、AIが「分かりません」って言いすぎるのも問題だってこと。全部「分かりません」って言われたら、使えない。バランスが重要なんです。

判断基準2:AIの出力に「信頼度」や「不確実性」が示されるか

次に、AIの出力に「信頼度」や「不確実性」が示されるか、ってのも判断基準になるかもしれない。

例えば、AIが「2025年の日本のGDPは約500兆円です(信頼度:中)」みたいに答えてくれたら、どうでしょう?この情報は中程度の信頼度だから、確認が必要だな、って判断できる。

でも、今のAIは基本的に、信頼度を教えてくれない。全部同じトーンで答える。だから、どの情報が確実で、どの情報が不確実か、判断がつかない。

でも、もしAIが信頼度を教えてくれたら、その情報をどう扱うか、判断できる。確実な情報はそのまま使えるし、不確実な情報は確認する。みたいな使い分けができる。

判断基準3:間違いを隠さず、透明性があるか

最後に、AIが間違いを隠さず、透明性があるか、ってのも判断基準になるかもしれない。

今のAIって、間違っていても、それを認めない。自信満々に間違った答えを出す。でも、もしAIが「実は、この部分は不確実です」って正直に言ってくれたら、どうでしょう?

その情報をどう扱うか、判断できる。で、AIの信頼性が上がる。

でも、ここで注意したいのは、AIが全部「不確実です」って言うのも問題だってこと。全部不確実だったら、使えない。バランスが重要なんです。

今すぐ使える:現状のAIでどう判断するか

で、この技術はまだ研究段階だから、今すぐ使えるわけじゃない。でも、現状のAIでも、ある程度の判断はできるんです。

現状のAI(ChatGPT、Claude、Gemini)での確認方法

まず、現状のAIでどう判断するか、って話です。

基本的に、AIの出力をそのまま信じるのは危険です。特に、専門知識が必要な分野や、数字が重要な資料なんかだと、確認が必要。

で、確認方法としては、複数のAIで同じ質問をして、答えを比較する、ってのが有効です。ChatGPT、Claude、Geminiで同じ質問をして、答えが一致するか確認する。で、一致しない部分は、確認が必要。

ちなみに、各AIの特徴や選び方については、過去にChatGPT 5.1、Grok 4.1、Gemini 3の徹底比較記事でも書いたので、参考にしてみてください。AIの選び方や判断基準を考える上で、役立つと思います。

でも、これって結構めんどくさいですよね。全部確認するとなると、時間がかかる。で、結局「AI使うの、めんどくさいな」ってなって、使わなくなる。

でも、もしAIが「この部分は不確実です」って教えてくれたら、その部分だけ確認すればいい。時間の節約になる。

プロンプトの工夫:AIに「不確実な点は正直に言って」と指示する

で、現状のAIでも、ある程度の判断はできる方法があります。それが、プロンプトの工夫です。

例えば、こんな感じでプロンプトを書く。

「〇〇について教えてください。ただし、不確実な点や自信のない部分は、正直に『これは不確実です』『この部分は自信がありません』と明記してください」

みたいな。で、AIに「不確実な点は正直に言って」って指示する。

これ、完全ではないけど、ある程度は効果があるんです。AIが「この部分は不確実です」って言ってくれることがある。で、その部分だけ確認すればいい。

でも、ここで注意したいのは、AIが全部「不確実です」って言うこともあるってこと。全部不確実だったら、使えない。バランスが重要なんです。

出力の検証方法:複数のAIで比較する、専門知識で確認する

で、出力の検証方法としては、複数のAIで比較する、ってのが有効です。

例えば、ChatGPT、Claude、Geminiで同じ質問をして、答えを比較する。で、一致しない部分は、確認が必要。

でも、これって結構めんどくさいですよね。全部確認するとなると、時間がかかる。

でも、もしAIが「この部分は不確実です」って教えてくれたら、その部分だけ確認すればいい。時間の節約になる。

あとは、専門知識で確認する、ってのも有効です。AIの出力を、専門知識がある人に確認してもらう。で、間違いがあれば修正する。

でも、これも結構めんどくさいですよね。全部確認するとなると、時間がかかる。

でも、もしAIが「この部分は不確実です」って教えてくれたら、その部分だけ確認すればいい。時間の節約になる。

Room8視点:実務でのAI活用で気をつけるべきこと

で、Room8での実務経験から、AI活用で気をつけるべきことを話しておきます。

クライアントへの提案時:AIの出力をそのまま使わない

まず、クライアントへの提案時は、AIの出力をそのまま使わない、ってのが重要です。

AIが生成した資料をそのまま使うと、間違った情報が混じっている可能性がある。で、それをクライアントに提出して、後で指摘されて慌てる、みたいな。

だから、AIの出力は必ず確認する。で、間違いがあれば修正する。特に、数字が重要な資料なんかだと、確認が必須です。

でも、これって結構めんどくさいですよね。全部確認するとなると、時間がかかる。で、結局「AI使うの、めんどくさいな」ってなって、使わなくなる。

でも、もしAIが「この部分は不確実です」って教えてくれたら、その部分だけ確認すればいい。時間の節約になる。

コワーキングスペースでの活用:AIの限界を理解して使う

次に、コワーキングスペースでの活用では、AIの限界を理解して使う、ってのが重要です。

AIは便利だけど、完璧じゃない。間違うこともある。で、その間違いに気づけないと、問題になる。

だから、AIの出力をそのまま信じるのではなく、確認が必要な部分は確認する。で、AIの限界を理解して使う。

でも、これって結構めんどくさいですよね。全部確認するとなると、時間がかかる。

でも、もしAIが「この部分は不確実です」って教えてくれたら、その部分だけ確認すればいい。時間の節約になる。

今後のAI選び:透明性や正直さも判断基準に加える

で、今後のAI選びでは、透明性や正直さも判断基準に加える、ってのが重要だと思います。

今までは、AIの性能や機能で選ぶことが多かった。でも、これからは、AIが「分かりません」とか「これは不確実です」って正直に言えるか、ってのも判断基準になるかもしれない。

例えば、Claude 4.5 Opusの記事でも書いたように、AIの進化は性能だけでなく、信頼性や透明性の向上も重要になってきています。AI選びの判断基準として、性能だけでなく、正直さや透明性も考慮する時代になってきている、って感じです。

で、その情報を元に、AIの出力をどう扱うか、判断できる。AIの信頼性が上がる。

でも、ここで注意したいのは、AIが全部「分かりません」って言うのも問題だってこと。全部「分かりません」だったら、使えない。バランスが重要なんです。

まとめ:AIの信頼性は「間違いを認められるか」で判断する時代へ

要点整理:AIが間違いを認められる技術の意義

で、まとめです。

OpenAIの「confessions」手法は、AIが「間違えた」と認められるようになる技術です。で、この技術が実現すると、AIの出力をより信頼できるようになる。

でも、この技術はまだ研究段階だから、今すぐ使えるわけじゃない。でも、この技術の方向性は、AI選びの判断基準を変えるかもしれない、って思うんです。

今すぐできること:AI選びの判断基準に「正直さ」を加える

で、今すぐできることとしては、AI選びの判断基準に「正直さ」を加える、ってのが有効だと思います。

今までは、AIの性能や機能で選ぶことが多かった。でも、これからは、AIが「分かりません」とか「これは不確実です」って正直に言えるか、ってのも判断基準にする。

で、その情報を元に、AIの出力をどう扱うか、判断できる。AIの信頼性が上がる。

あとは、プロンプトの工夫で、AIに「不確実な点は正直に言って」って指示する、ってのも有効です。完全ではないけど、ある程度は効果がある。

結論:完璧なAIを待つのではなく、AIの限界を理解して使うことが重要

で、最後に、結論です。

完璧なAIを待つのではなく、AIの限界を理解して使うことが重要だと思います。

AIは便利だけど、完璧じゃない。間違うこともある。で、その間違いに気づけないと、問題になる。

だから、AIの出力をそのまま信じるのではなく、確認が必要な部分は確認する。で、AIの限界を理解して使う。

でも、もしAIが「この部分は不確実です」って教えてくれたら、その部分だけ確認すればいい。時間の節約になる。で、AIの活用も進む。

で、この技術が実現すると、AIの信頼性が上がる。で、AIの活用も進む。って思うんです。

でも、ここで注意したいのは、AIが全部「不確実です」って言うのも問題だってこと。全部不確実だったら、使えない。バランスが重要なんです。

結局のところ、AIの信頼性は「間違いを認められるか」で判断する時代になるかもしれない、って思うんです。で、その情報を元に、AIの出力をどう扱うか、判断できる。AIの活用も進む。

ってことで、今日はこの辺で。AIの信頼性について、一緒に考えていきましょう。