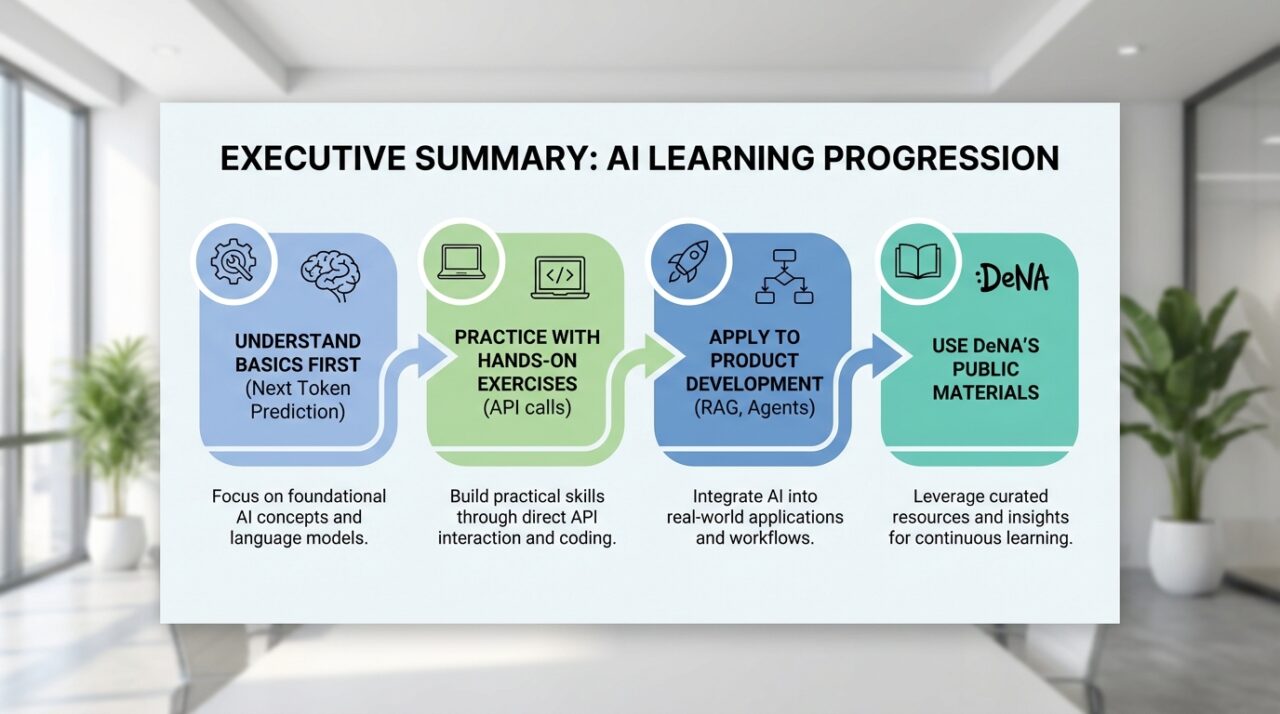

DeNAのLLM勉強会資料は、基礎から応用までを実践的ハンズオンで学べる構成。Next Token Predictionからエージェント設計、RAG、マルチモーダル、ツール連携まで、スライドとコードが公開。3時間の学習プランと実務適用を提案。

- DeNAの公開資料は、スライドとコードが全公開された実践的ハンズオンで、基礎から応用まで段階的に学べる点が特徴。

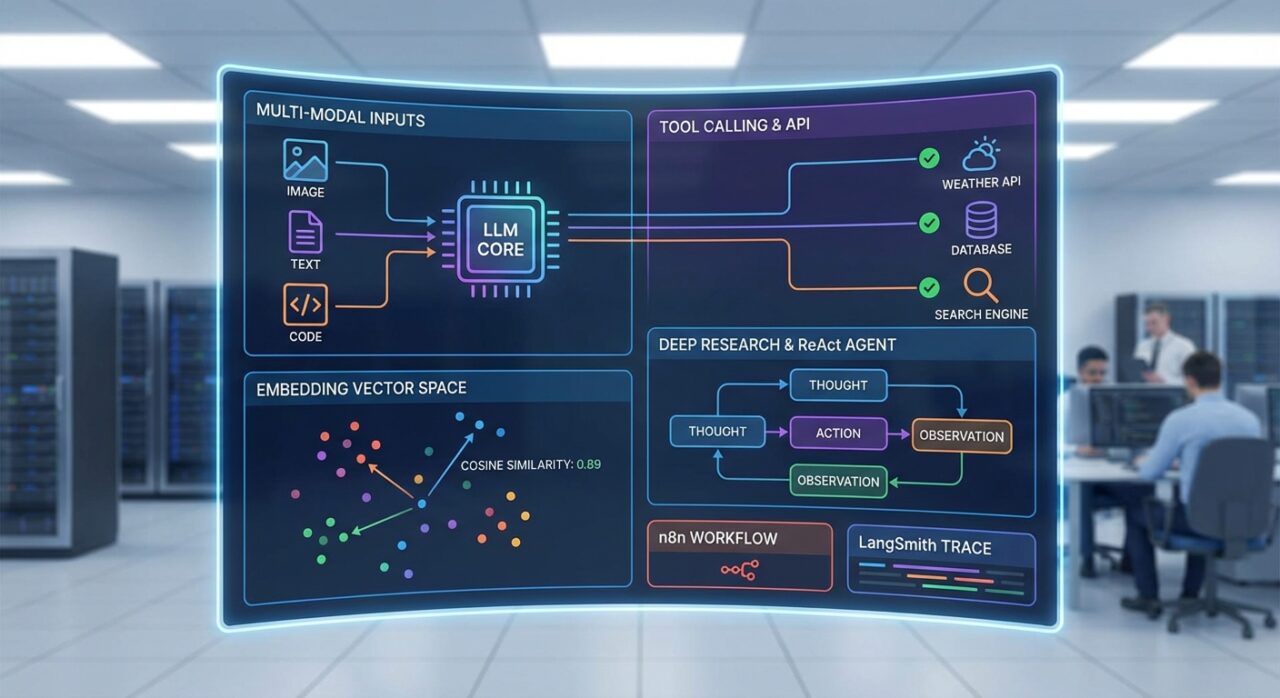

- Next Token Prediction、Instruction Tuning、Reasoning、プロンプトエンジニアリングから、RAG・ReAct/Reflexion・マルチモーダル・コード実行・Tool Calling・Embeddingまで実務で使える手法を網羅。

- 学習計画は約3時間の構成。実際に触れて動かすことで理解を深め、自分のプロジェクトへ即適用を推奨。

こんにちは、Room8オーナーの鶴田です!

LLMを学びたいけど、どこから始めればいいか分からない。勉強会の資料を探してるけど、実践的なコード例が少ない。体系的に学べるリソースが欲しい…なんて悩み、ありませんか?

僕も実際にLLMを学び始めた時、同じような悩みがありました。基礎知識は分かるけど、実際にどう使えばいいか分からない。APIの呼び出し方から、複数のLLMを組み合わせる方法まで、実践的な情報が少なくて困ったんですよね。

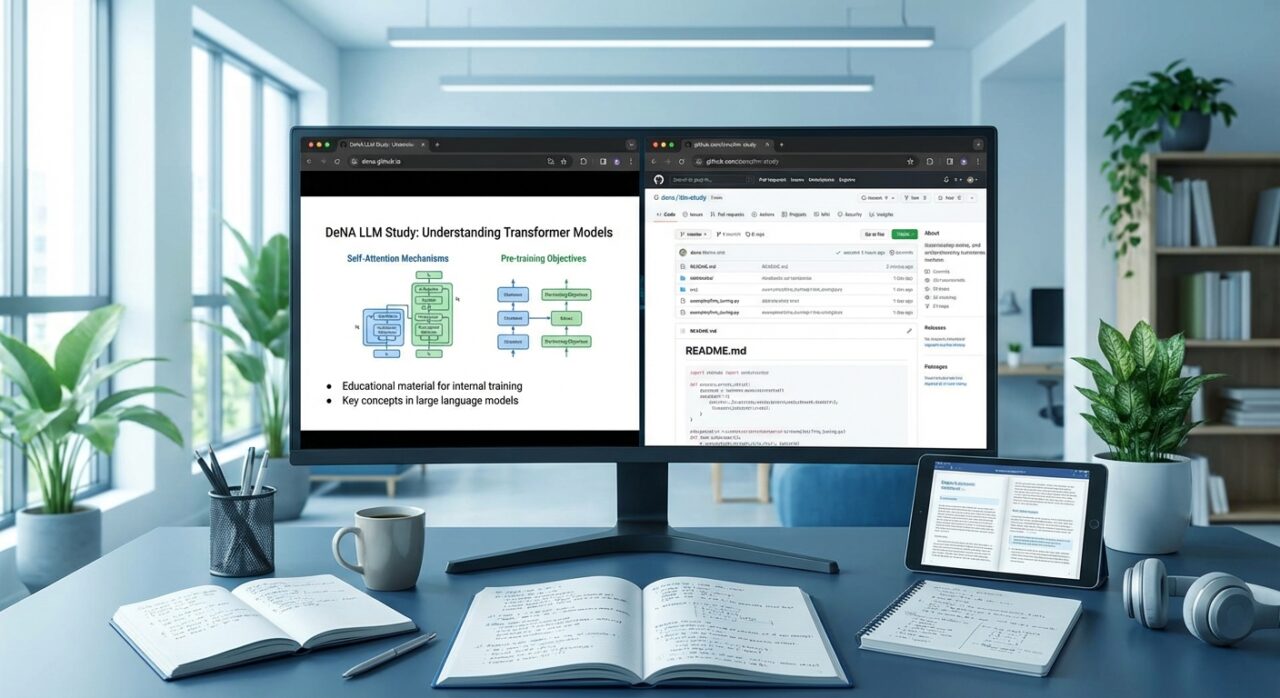

でも、最近DeNAが公開したLLM勉強会の資料を見て、「これ、めちゃくちゃ実践的じゃないか」って思ったんです。スライドもソースコードも全部公開されている。で、実際に手を動かしながら学べるハンズオン形式になっている。

これ、LLMを学びたい人にとって、すごく価値のあるリソースだと思うんです。だから、今日はそのDeNAのLLM勉強会資料を活用した、実践的な学習ガイドを書こうと思います。

LLMの基礎知識:Next Token Predictionから理解する仕組み

Next Token Predictionとは?

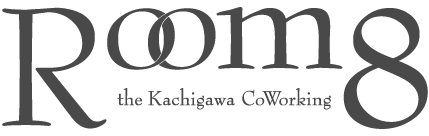

LLMって、結局何をしてるのか、って話なんですけど。実は、LLMは「次のトークンを予測する」ってことを繰り返してるだけなんです。

例えば、「This is a ( )」って文章があったとします。LLMは「次のカッコに入るのは何?」って問題を解いてる。で、「pen」とか「book」とか、可能性の高い単語を予測する。

これがNext Token Prediction。次のトークン(単語)を予測する仕組みです。

で、この予測を繰り返すことで、文章全体を生成してる。これがLLMの基本的な仕組みなんです。

でも、ここで面白いのが、LLMは「自己回帰ループ」って仕組みで動いてるってこと。入力シーケンスから確率を計算して、サンプリングして、予測トークンを生成する。で、その予測トークンを入力シーケンスに追加して、また次のトークンを予測する。これを繰り返す。

温度TやTop-k/pで調整することで、生成される文章の多様性をコントロールできる。温度が高いと多様な文章が生成されるし、低いと確実性の高い文章が生成される。

これ、実務でLLMを使う上で、すごく重要なことだと思うんです。LLMがどう動いてるか理解してると、プロンプトの書き方も変わるから。

Instruction TuningとReasoning

で、LLMにはInstruction Tuningって仕組みがあるんです。これは、LLMに指示に従うように訓練する技術。で、これによって、LLMは「〇〇について教えて」って指示されたら、それに従って答えてくれるようになる。

でも、ここで重要なのが、Reasoning/Thinking機能を持つモデルと持たないモデルの違い、ってことです。

GPT-5、o1、Gemini-2.5-Proみたいなモデルは、推論や思考のプロセスを経てから応答を生成する。で、GPT-4o、Gemini-2.5-Flash-Liteみたいなモデルは、推論や思考の機能を持たず、直接応答を出力する。

これ、実務でLLMを選ぶ際の判断基準になるかもしれない、って思うんです。複雑な推論が必要なタスクなら、Reasoning機能を持つモデルを選ぶ。で、シンプルなタスクなら、Reasoning機能がないモデルでも十分。

ちなみに、各モデルの特徴や選び方については、過去にChatGPT 5.1、Grok 4.1、Gemini 3の徹底比較記事でも書いたので、参考にしてみてください。

プロンプトエンジニアリングの基本

で、LLMを使う上で、プロンプトエンジニアリングってのが重要なんです。プロンプトの書き方で、LLMの出力の質が大きく変わる。

でも、ここで注意したいのが、プロンプトに指示を足し続けるのではなく、全体を見直す重要性、ってことです。

プロンプトがうまく動かない時、「もっと指示を足そう」って思うじゃないですか。でも、それって逆効果になることが多い。プロンプトが複雑になりすぎて、LLMが混乱する。

だから、プロンプトがうまく動かない時は、一旦全体を見直す。で、シンプルな構造に戻す。みたいなアプローチが有効なんです。

これ、DeNAの勉強会でも強調されてたポイントで、実務でLLMを使う上で、すごく重要なことだと思うんです。

実践的なハンズオン:API呼び出しから複数LLMの組み合わせまで

基本的なAPI呼び出し

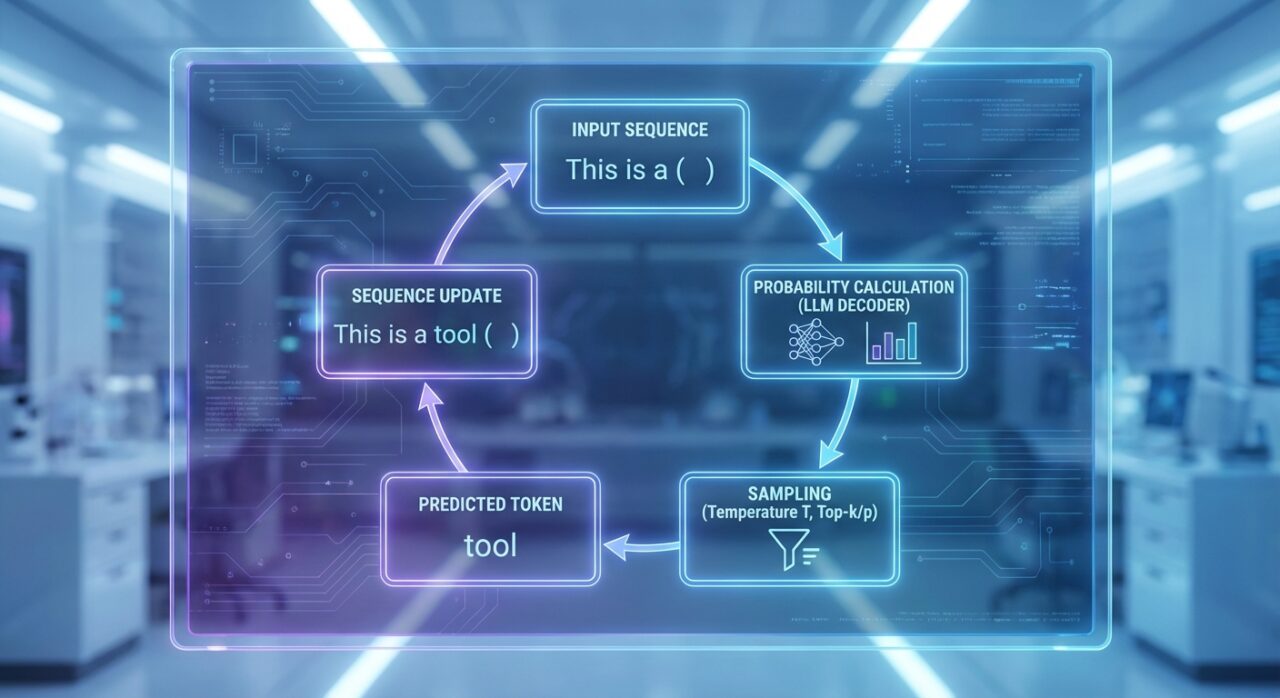

で、LLMを実際に使うには、APIを呼び出す必要がある。DeNAの勉強会では、Pythonを使ったAPI呼び出しの基本から学べる。

穴埋め形式のソースコードが用意されてるから、短時間でハンズオンが成り立つ。で、実際に手を動かしながら学べる。

これ、すごく実践的だと思うんです。理論だけじゃなく、実際にコードを書いて動かしてみる。で、その過程で、LLMの使い方が分かってくる。

GitHubで公開されているソースコード(https://github.com/DeNA/llm-study20251201)を見ると、基本的なAPI呼び出しから、構造化出力、複数LLMの組み合わせまで、段階的に学べる構成になってる。

構造化出力の実装

で、LLMの出力を構造化する方法も学べる。JSON形式で出力させたり、特定のフォーマットで出力させたり。

これ、実務でLLMを使う上で、すごく重要なことだと思うんです。LLMの出力をそのまま使うのではなく、構造化して使う。で、その構造化されたデータを、他のシステムと連携する。

DeNAのコード例を見ると、構造化出力の実装方法が分かりやすく書かれてる。で、実際に動かしてみると、どういう風に構造化されるか、理解できる。

複数LLMを組み合わせて問題を解く

で、さらに実践的なのが、複数LLMを組み合わせて問題を解くって演習です。

LLMを1つだけ使うのではなく、複数のLLMを組み合わせる。で、それぞれのLLMの強みを活かして、問題を解く。

これ、実務でLLMを使う上で、すごく重要な思考なんです。1つのLLMに全部任せるのではなく、複数のLLMを組み合わせる。で、それぞれのLLMの特性を活かす。

DeNAの勉強会では、誘導問題の形で実践できる。で、実際にコードを書いて動かしてみると、どういう風に組み合わせるか、理解できる。

プロダクト開発に必要な応用知識

ファインチューニングと強化学習の違い

で、LLMを使ったプロダクト作りでは、データをどう活用するか、ってのが重要なんです。

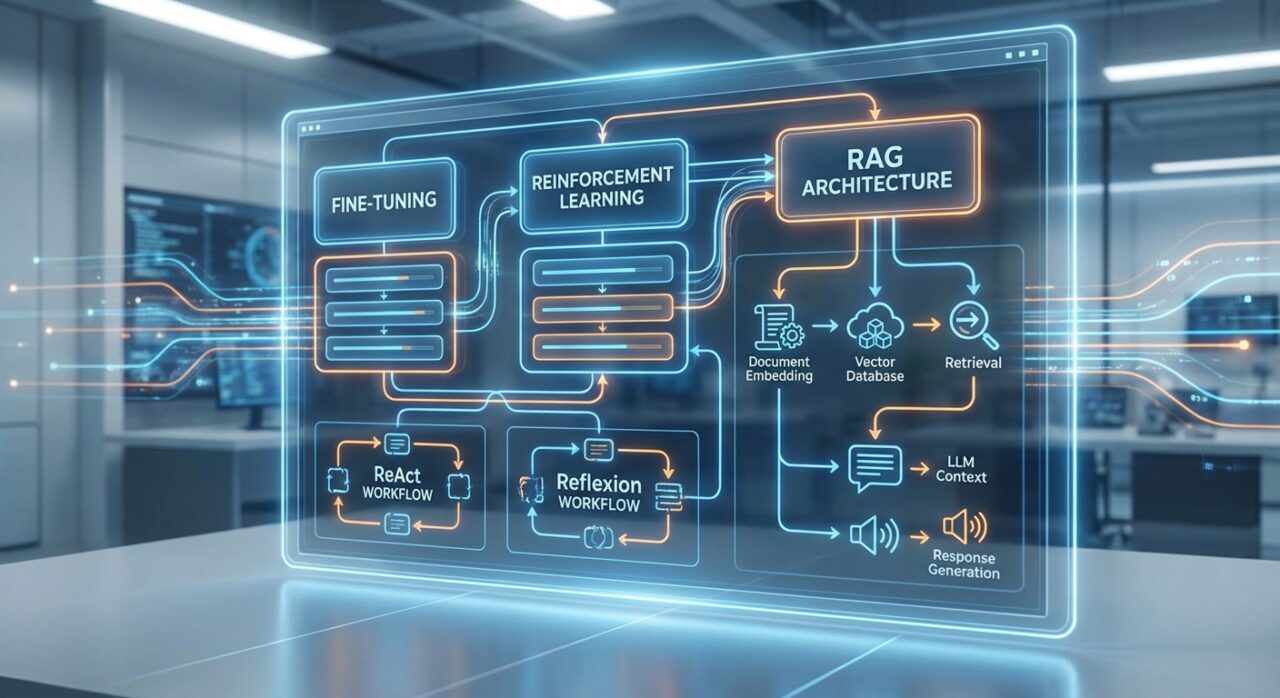

ファインチューニングと強化学習、この2つの違いを理解してると、プロダクト開発の方向性が決まる。

ファインチューニングは、既存のモデルに特定のタスクを学習させる技術。で、強化学習は、モデルの行動に対して報酬を与えて、最適な行動を学習させる技術。

これ、使い分けが重要なんです。ファインチューニングは、特定のタスクに特化させたい時に使う。で、強化学習は、モデルの行動を改善したい時に使う。

DeNAの勉強会では、この違いが分かりやすく解説されてる。で、実際のプロダクト開発でどう使い分けるか、判断基準が分かる。

コンテキストエンジニアリングとRAG

で、データを活用してパーソナライズを実現するには、コンテキストエンジニアリングが重要、ってのがDeNAの勉強会で強調されてたポイントです。

コンテキストエンジニアリングって、LLMに適切な文脈情報を提供する技術。で、その一種と言えるのがRAG(Retrieval-Augmented Generation)。

RAGの基本構造は、シンプルなんです。まず、文書をEmbeddingに変換して、ベクトルデータベースに保存する。で、質問が来たら、関連する文書を検索して、その文書をコンテキストとしてLLMに渡す。で、LLMがそのコンテキストを元に回答を生成する。

これ、実務でLLMを使う上で、すごく重要な技術だと思うんです。LLMの知識だけでは答えられない質問でも、RAGを使えば答えられる。で、パーソナライズされた回答ができる。

DeNAの勉強会では、RAGの基本構造が詳しく解説されてる。で、実際に実装する方法も学べる。

エージェントの基本:ReActとReflexion

で、さらに発展的なのが、エージェントの設計です。

エージェントって、LLMにTool Calling機能を追加して、外部のツールやAPIを呼び出せるようにする技術。で、その基本となるのがReActとReflexion。

ReActは、ReasoningとActingを組み合わせた手法。LLMが推論して、行動を決定する。で、その行動の結果を見て、また推論する。これを繰り返す。

Reflexionは、LLMが自分の行動を振り返って、改善する手法。失敗したら、なぜ失敗したか分析して、次は改善する。

これ、実務でLLMを使う上で、すごく重要な技術だと思うんです。LLMを単なるチャットボットとして使うのではなく、エージェントとして使う。で、外部のツールやAPIと連携して、複雑なタスクを実行する。

DeNAの勉強会では、ReActとReflexionの仕組みが詳しく解説されてる。で、実際にエージェントを設計する方法も学べる。

ちなみに、エージェント機能の進化については、過去にClaude 4.5 Opusの記事でも書いたので、参考にしてみてください。

発展的なハンズオン:マルチモーダルからエージェント実装まで

マルチモーダル入力とコード実行

で、さらに発展的なハンズオンとして、マルチモーダル入力やコード実行機能を体験できる。

マルチモーダル入力って、テキストだけでなく、画像や音声も入力できる機能。で、LLMがその画像や音声を理解して、回答を生成する。

コード実行機能は、LLMがコードを生成して、それを実行できる機能。で、実行結果を見て、またコードを改善する。

グラウンディングって、LLMの回答を、実際のデータソースに基づいて検証する技術。で、LLMが生成した情報が、実際のデータと一致するか確認する。

これ、実務でLLMを使う上で、すごく重要な機能だと思うんです。テキストだけじゃなく、画像や音声も扱える。で、コードも実行できる。で、生成した情報の信頼性も確認できる。

Tool CallingとEmbedding

で、Tool CallingとEmbeddingの実践的な演習もできる。

Tool Callingは、LLMが外部のツールやAPIを呼び出せる機能。で、Embeddingは、テキストをベクトルに変換する技術。で、そのベクトルを使って、コサイン類似度を計算して、関連する文書を検索する。

DeNAの勉強会では、Embeddingを呼んでコサイン類似度を計算してみる演習がある。で、実際に手を動かしてみると、どういう風に使うか、理解できる。

これ、実務でLLMを使う上で、すごく重要な技術だと思うんです。Tool Callingで外部のツールと連携できる。で、Embeddingで関連する文書を検索できる。

Deep ResearchとReAct Agent

で、さらに発展的なのが、Deep Researchの内部構造を考えてみる演習です。

Deep Researchって、LLMが複数の情報源を検索して、その情報を統合して、包括的な回答を生成する技術。で、その内部構造を理解してると、自分でも実装できる。

ReAct Agentは、ReActの手法を使って、エージェントを実装する技術。で、実際にエージェントを設計して、動かしてみる。

これ、実務でLLMを使う上で、すごく重要な技術だと思うんです。Deep Researchで包括的な情報を取得できる。で、ReAct Agentで複雑なタスクを実行できる。

便利なツール:n8nとLangSmith

で、最後に、n8nやLangSmithみたいな便利なツールを使ってみる演習がある。

n8nは、ワークフロー自動化ツール。で、LLMと連携して、複雑なワークフローを構築できる。

LangSmithは、LLMアプリケーションの開発・デバッグ・モニタリングツール。で、LLMの動作を可視化して、問題を特定できる。

これ、実務でLLMを使う上で、すごく便利なツールだと思うんです。n8nでワークフローを自動化できる。で、LangSmithでLLMの動作を可視化できる。

DeNAの公開資料を活用した学習方法

スライドとソースコードの活用

で、DeNAが公開している資料は、すごく実践的だと思うんです。

スライド(https://dena.github.io/llm-study20251201/)を見ると、LLMの基礎知識から応用まで、体系的に学べる構成になってる。で、GitHubのソースコード(https://github.com/DeNA/llm-study20251201)を見ると、実際に動かせるコードが用意されてる。

これ、LLMを学びたい人にとって、すごく価値のあるリソースだと思うんです。理論だけじゃなく、実際に手を動かして学べる。

僕も実際にスライドを見て、コードを動かしてみたんですけど、めちゃくちゃ勉強になりました。基礎知識から応用まで、段階的に学べる構成になってる。

勉強会の構成を参考にした学習計画

で、DeNAの勉強会は、約3時間の講義&ハンズオン形式で構成されてる。

基礎知識(Next Token Prediction、Instruction Tuning、Reasoning、プロンプトエンジニアリング)から始まって、実践的なハンズオン(API呼び出し、構造化出力、複数LLMの組み合わせ)を経て、プロダクト開発に必要な応用知識(強化学習、ファインチューニング、コンテキストエンジニアリング、RAG、ReAct/Reflexion)から発展的なハンズオン(マルチモーダル入力、グラウンディング、コード実行、Tool Calling、Embedding、Deep Research設計、ReAct Agent、n8n、LangSmith)まで体験できる。

これ、個人で学習する際の進め方としても、すごく参考になると思うんです。基礎から応用まで、段階的に学ぶ。で、実際に手を動かしながら学ぶ。

Room8視点でのLLM活用アイデア

コワーキングスペース運営での活用例

で、Room8での実務経験から、LLMの活用アイデアを話しておきます。

コワーキングスペース運営では、会員管理の自動化とか、イベント企画の支援とか、コミュニティ運営の効率化とか、LLMを活用できる場面が結構あるんです。

例えば、会員からの問い合わせに自動で回答するとか、イベントの企画案を自動で生成するとか。で、その生成された内容を、人間が確認して、使う。

これ、すごく効率的だと思うんです。LLMに任せられる部分は任せて、人間は判断が必要な部分に集中する。

でも、ここで注意したいのが、LLMの出力をそのまま使わない、ってことです。必ず確認して、間違いがあれば修正する。で、LLMの限界を理解して使う。

実務でのLLM選び方

で、実務でLLMを選ぶ際の判断基準として、用途に応じたモデル選択、コストと性能のバランス、信頼性の判断基準、ってのが重要だと思うんです。

用途に応じたモデル選択って、複雑な推論が必要なタスクなら、Reasoning機能を持つモデルを選ぶ。で、シンプルなタスクなら、Reasoning機能がないモデルでも十分。

コストと性能のバランスって、性能が高いモデルはコストも高い。で、コストを抑えたいなら、性能が低いモデルを選ぶ。でも、そのバランスをどう取るか、判断が難しい。

信頼性の判断基準って、LLMの出力をそのまま信じていいのか、確認が必要なのか、判断する基準。で、これについては、過去にAIが間違いを告白する技術の記事でも書いたので、参考にしてみてください。

まとめ:LLMを学ぶなら、基礎を理解してから実践することが重要

要点整理:DeNAの公開資料で体系的に学べる

で、まとめです。

DeNAが公開したLLM勉強会の資料は、LLMの基礎知識から応用まで、体系的に学べる構成になってる。で、実際に手を動かしながら学べるハンズオン形式。

スライドとソースコードが全部公開されてるから、すぐに始められる。で、基礎から応用まで、段階的に学べる。

これ、LLMを学びたい人にとって、すごく価値のあるリソースだと思うんです。

今すぐできること:DeNAの公開資料を実際に触ってみる

で、今すぐできることとしては、DeNAの公開スライドとソースコードを実際に触ってみる、ってのが有効だと思います。

スライドを見て、基礎知識を理解する。で、ソースコードを動かして、実際にLLMを使ってみる。で、その過程で、LLMの使い方が分かってくる。

あとは、自分のプロジェクトに応用してみる、ってのも有効です。DeNAのコード例を参考にしながら、自分のプロジェクトに合わせてカスタマイズする。で、実際に動かしてみる。

結論:LLMを学ぶには、基礎を理解してから実践することが重要

で、最後に、結論です。

LLMを学ぶには、基礎を理解してから実践することが重要だと思います。

Next Token Predictionからエージェント設計まで、基礎知識を理解してから、実際にコードを書いて動かしてみる。で、その過程で、LLMの使い方が分かってくる。

でも、ここで注意したいのが、理論だけじゃなく、実際に手を動かして学ぶ、ってことです。DeNAの勉強会みたいに、ハンズオン形式で学ぶ。で、その過程で、実践的なスキルが身につく。

で、公開されている資料を活用することで、効率的に学習できる。DeNAのスライドとソースコードは、すごく実践的なリソースだと思うんです。

Room8でも、LLMを活用したサービス改善を進めてる。で、その過程で、LLMの使い方が分かってきた。基礎を理解してから実践する、ってのが重要だと思うんです。

ってことで、今日はこの辺で。LLMを学びたい人は、DeNAの公開資料を活用して、一緒に学んでいきましょう。